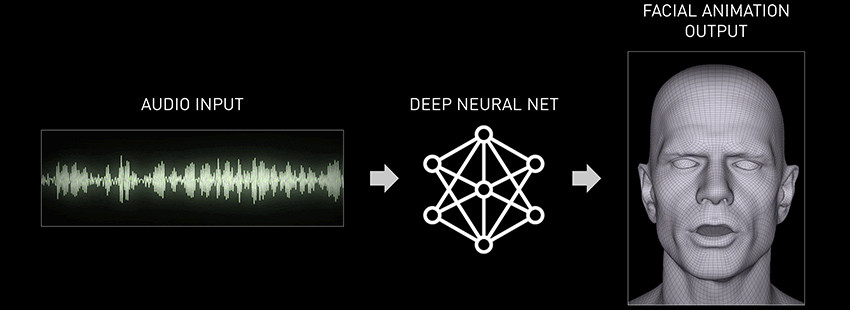

Audio2Face convierte el audio en gestos labiales animados. Una de las aplicaciones creadas como parte de Omniverse publicada en beta abierta es Audio2Face, una herramienta que simplifica el complejo proceso de animación de una cara en una entrada de audio.

Fue desarrollado como una aplicación dentro de Omniverse, que se encuentra en la plataforma y lleva sus posibilidades a otras aplicaciones integradas en el flujo de trabajo. Como elemento de entrada sirve cualquier archivo de audio popular, como .wav o .mp3. y la salida es una animación facial realista, ya sea como una caché de geometría o como una transmisión en vivo.

Audio2Face es una tecnología basada en IA que genera movimiento facial y sincronización completa de labios a partir de una fuente de audio. Ofreciendo varias formas de explotar la tecnología; se puede usar en tiempo de ejecución o para generar animación facial para canalizaciones de creación de contenido más tradicionales.

Canalizaciones de Audio2Face

También proporciona una canalización de transferencia de caracteres completa que proporciona al usuario un flujo de trabajo simplificado que te permite conducir tus propios personajes con las tecnologías Audio2Face.

Audio2Face simplifica la animación de un personaje 3D para que coincida con cualquier pista de voz/audio. No está dirigido a la animación de gama más alta como largometrajes, sin embargo, proporciona excelentes personajes de animación con sincronización labial en juegos, personajes de fondo NPC o para asistentes digitales en tiempo real.

Puedes usar la aplicación para crear aplicaciones interactivas en tiempo real o trabajar sin conexión y exportar cachés para usarlos en una canalización de animación facial tradicional. Audio2Face se puede ejecutar en vivo o bakear y exportar, depende de lo que quieras hacer.

Audio2Face surgió de un conjunto de reuniones en torno al año 2018, cuando varios desarrolladores de juegos asistieron a una conferencia organiza por Nvidia y comentaron el problema y tiempos de trabajo en la sincronización labial.

¿Qué puede hacer Nvidia en este tema?

Se podría tal vez con la ayuda con el aprendizaje profundo u otra tecnología, ayudar a acelerar y satisfacer estas demandas de producción?

En ese momento no era raro que un equipo de desarrollo de juegos estuviera en captura de movimiento durante dos años y medio seguidos. Eso solo para un juego.

Estos problemas de producción realistas, más la dificultad general del proceso que consume mucho tiempo y trabajo a la hora de crear animación facial 3D de alta calidad, les llevaron a empezar a pensar en cómo resolver estos problemas.

Así nació la idea de Audio2Face, la aplicación utiliza el RTX Renderer ya que Audio2Face es una parte del marco Omniverse. No está pensado como una aplicación de demostración, es una herramienta para permitir a los desarrolladores construir aplicaciones serias.

Por ejemplo, es de esperar que esto se integre con MetaHuman de Epic Games. Esto permite que Audio2face conduzca a los personajes de UE4 en tiempo real.

Interactúa con otros softwares gracias a Omniverse

Omniverse ofrece facilidades de ida y vuelta de activos dentro y fuera de programas como UE4 y Autodesk Maya. Audio2Face actualmente se puede exportar como una caché Maya o una caché USD Universal Scene Description.

Antes de entrar en canalizaciones específicas con socios como Epic Games, Nvidia quiere comentarios de clientes beta. Ya que juegan un papel crítico en el desarrollo de la plataforma Omniverse. Para que Audio2Face tenga éxito, debe hacerlo permitiendo a los desarrolladores construirlo en canalizaciones más complejas. Kerris ve esta retroalimentación cercana de los clientes como un objetivo principal para el equipo tras hacer pública la versión beta.

El programa Audio2Face ahora está en beta abierta, pero esto es solo una vista previa preliminar, hay muchas características que aún están por llegar. Por ejemplo, Audio2Face dispone de un conjunto de controles de inferencia de post que le permiten ajustar las poses resultantes de la animación de salida en función de los datos entrenados.

Crear expresiones combinando emociones

Esto le permite ajustar la amplitud de su rendimiento, entre otras cosas. También habrá formas que permitan al usuario cambiar o combinar diferentes emociones para afinar las expresiones y respuestas del personaje. Todos estos podrán ser animados en una línea de tiempo que permita a los usuarios desvanecerse dentro y fuera de las emociones; como el asombro, la ira, el disgusto, la alegría, el dolor, etc. en una versión futura.

Las versiones posteriores incluirán características más detalladas basadas en audio, incluyendo:

- Ojos y mirada

- Dientes y lengua

- Movimiento de la cabeza utilizando una estructura conjunta, todo impulsado por audio.

- Controles de alto nivel para que puedas dirigir rápidamente el estado de ánimo y la emoción del personaje.

Todo impulsado por audio con controles de usuario adicionales. El objetivo es utilizar una interfaz muy simple para obtener un rendimiento completo de alta calidad. Ahorrando o disminuyendo parte del trabajo que se tiene que hacer tradicionalmente en animaciones CG.

Nvidia Research está utilizando el aprendizaje automático para producir una animación plausible de lo que los ojos de un personaje están haciendo mientras hablamos. Para ello se basan solo en formas de onda de audio. Entrenado los ojos para que hagan un movimiento natural, y luego controlarlo o amplificarlo si lo necesitamos.

Lo que está por desarrollar en Audio2Face

En una versión futura, las emociones de los personajes también se pueden mezclar. Pensemos en una combinación de posturas FACS integradas en una red neuronal. De forma que no tengamos que ajustar cada forma FACS individualmente para el flujo de trabajo común laborioso.

Estamos viendo cómo podemos mezclar y combinar emociones para obtener el rendimiento que necesitamos. El sistema anima no solo la piel de la cara de un personaje, sino también la cara completa, los globos oculares, los párpados, el movimiento de la cabeza, los dientes, la lengua y el cuello. Todos estos aspectos están controlados por la animación basada en audio y moderados por los vectores emocionales.

Audio2Face simplifica la animación de un personaje 3D para que coincida con cualquier pista de voz. Tanto si estás animando personajes para un juego o para una película. Como para asistentes digitales en tiempo real o simplemente por diversión. Puedes usar la aplicación para aplicaciones interactivas en tiempo real o como una herramienta tradicional de creación de animaciones faciales.

Más información y comentarios en el foro, sigue leyendo…