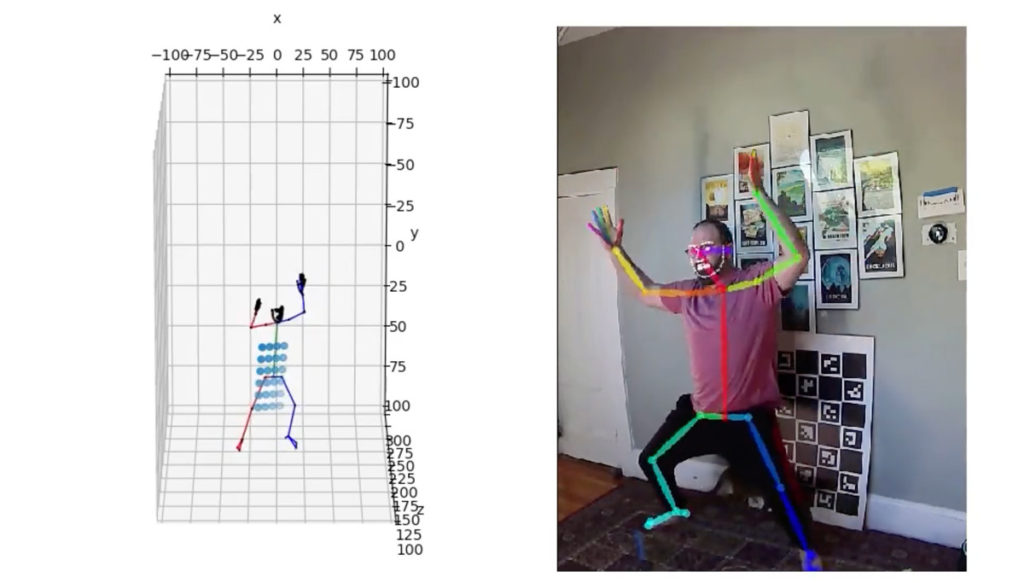

FreeMoCap sistema de captura de movimiento óptico. El investigador Jonathan Matthis ha lanzado el Proyecto FreeMoCap. Un ambicioso intento de desarrollar un sistema de captura de movimiento óptico sin marcadores de bajo coste.

El prometedor marco de código abierto puede generar movimiento esquelético de cuerpo completo a partir de las imágenes de un actor capturadas por dos cámaras web USB, y viene con un complemento de integración de Blender.

Mathis dice que su objetivo final es permitir que un niño de 14 años sin preparación técnica y sin asistencia externa pueda recrear un sistema de captura de movimiento de grado de investigación por un coste inferior a los 100 dólares.

FreeMoCap todavía está en fase de iniciación en su desarrollo, pero ya se pueden los avances y la verdad es que prometen ser muy buenos.

Conocimientos técnicos para probarlo ahora

No hay ninguna documentación, por lo que si decides probarlo ahora necesitarás un poco de conocimientos técnicos para que funcione, y el repositorio de GitHub viene con el descargo de responsabilidad de que todavía no está realmente listo para todos los usuarios.

El sistema procesa el material de archivo de vídeo de un actor para calcular una pose para cada fotograma, y luego lo traduce en datos de movimiento esquelético que podrían reorientarse a un personaje 3D.

Está destinado a ser independiente del hardware, el mínimo es dos cámaras web USB de tipo normal.

Buenos resultados

Entre los archivos de descarga podemos ver un tablero CharUco, la imagen se incluye con el código fuente del proyecto, se utiliza como punto de referencia espacial, pero no se requieren marcadores en el cuerpo del actor.

Y los resultados se ven bastante bien en el video a pesar de cierto ruido, particularmente cuando una extremidad oscurece a otra. Pero la colocación del pie, que a menudo suele dar problemas con los sistemas sin marcadores, se ve bastante sólida.

El sistema incluso captura las posiciones de los dedos y los rasgos faciales, y los desarrolladores planean agregar soporte para el seguimiento de pupilas en el futuro.

FreeMoCap se basa en herramientas de código abierto del campo de las ciencias, el propio Matthis es profesor asistente en el departamento de biología de la Northeastern University en los EE. UU.

La versión inicial utiliza OpenPose y DeepLabCut para el seguimiento sin marcadores con un backend basado en Anipose para la calibración de la cámara.

Complemento experimental de Blender

Para generar datos de animación, el proyecto viene con un complemento experimental de Blender. Además el proyecto completo eventualmente se empaquetará en una compilación personalizada de Blender.

Actualmente no parece haber una manera de exportar datos en un formato que se pueda usar en otras aplicaciones DCC. Pero Matthis ha comentado que mucha gente que se dedica a la animación se beneficiaría del sistema, y que plane poder exportar también en otros formatos. Como C3D, CSV y JSON.

El código fuente de The FreeMoCap Project está disponible bajo una licencia GPL. El plugin Blender está disponible bajo una licencia AGPL.

El sistema requiere Anaconda, OpenPose y CUDA, por lo que también necesitarás una GPU Nvidia para usarlo, y se instala desde la línea de comandos.

FreeMoCap sistema de captura de movimiento óptico totalmente libre

El sistema Free Motion Capture (FreeMoCap) aprovecha el software de captura de movimiento sin marcadores de vanguardia como por ejemplo, OpenPose, DeepLabCut, etc. Para crear una canalización optimizada de un solo clic para la reconstrucción cinemática en 3D.

Este sistema funciona con hardware de cámara arbitrario y proporciona métodos para la grabación síncrona de cámaras cableadas, por ejemplo, cámaras web USB. Así como la sincronización post-hoc de cámaras independientes como GoPro.

El proyecto FreeMoCap enfatiza la facilidad de uso, con el objetivo final de desarrollar un sistema que permita a un niño de 14 años sin preparación técnica y sin asistencia externa recrear un sistema de captura de movimiento en términos de investigación por menos de 100 dólares.

Antes de nada verifica tener instalado lo siguiente

- Anaconda

- CUDA

- OpenPose

- Dos o más cámaras web USB conectadas a puertos USB viables, los concentradores USB normalmente no funcionan.

- Cada grabación debe empezar con una vista sin obstáculos con una placa CharUco generada con comandos Python.

Instrucciones de instalación para FreeMoCap

Abrir un indicador de Anaconda en Windows o en cualquier terminal en Mac/Linux. Y escribir los comandos necesarios que luego indicaremos en el foro.

Desarrollo e investigación de FreeMoCap sistema de captura de movimiento

El laboratorio de investigación de neurociencia del movimiento humano (HuMoN), busca comprender las bases neuronales del comportamiento humano natural en entornos del mundo real. Para ello se enfoca en los procesos de recopilación de información visuales que apoyan los movimientos balísticos de cuerpo completo. Como caminar, correr, saltar, etc.

Avanzan en los límites de la frontera científica mediante el desarrollo de nuevos métodos de investigación basados en tecnologías emergentes. Con ellas se obtienen mediciones de grado de investigación de las actividades humanas que anteriormente estaban fuera del alcance del análisis científico. Tanto en entornos naturales sin restricciones como en entornos de laboratorio controlados.

Su investigación busca construir puentes metodológicos y teóricos entre campos de investigación de otra manera dispares que se relacionan con el comportamiento humano natural.

Como la biomecánica musculoesquelética y la neurociencia visual, con el fin de desarrollar una comprensión científica más completa y holística del comportamiento humano natural.

Más información, detalles y comentarios en el foro, sigue leyendo…

Además del video, dejo el enlace a la página del proyecto y enlace al código.